FramePack Studioを導入してみよう!インストール手順まとめ

AI動画生成界の庶民の味方RTX3060(12GB版)を使用して絶賛実験中!

今回は「FramePackStudio」のインストール方法をご紹介します!

このツールは、

本家FramePack

FramePack F1

FramePack-eichiのエンドフレーム合成処理

これらすべてを1つの画面で切り替え&実行可能な上、

ジョブストック機能まで搭載した、ローカルAI動画を生成をする上ですばらしい最強統合ツールです。詳しくはこちらの記事へ

🔶「FramePackStudio」のインストール

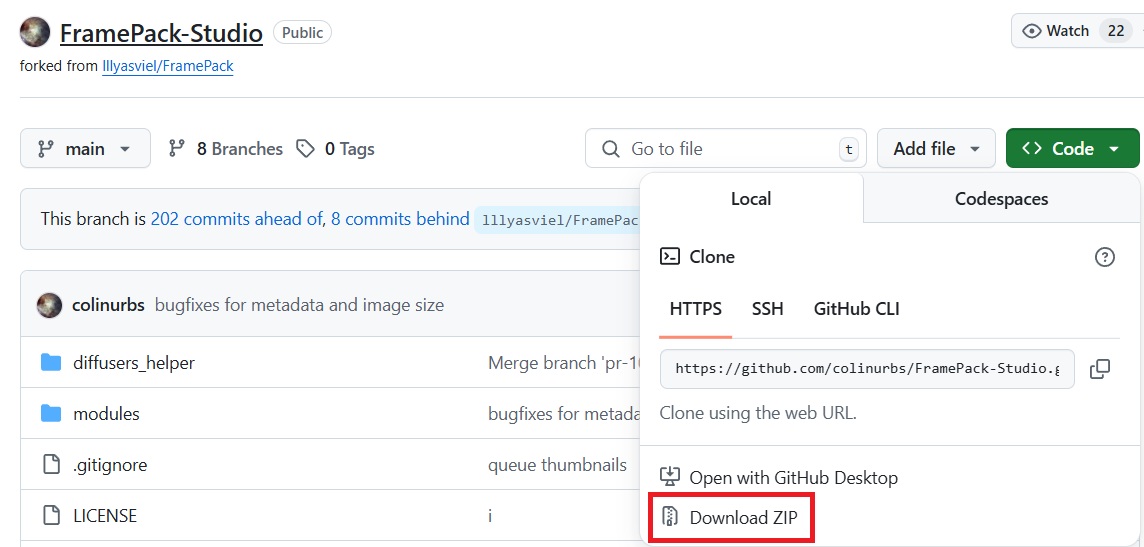

こちらのGitHubサイトよりFramePackStudioをダウンロード。

👆緑のcodeボタンクリックでDownloadZIPからダウンロードします。

フォルダを任意の場所に展開し、

必要に応じて仮想環境を必ず有効にして下さい。(理由はこちら)

コマンドプロンプトで、先ほど展開した FramePackStudio フォルダに移動し、以下のコマンドを実行します(※仮想環境での実行を推奨します)。

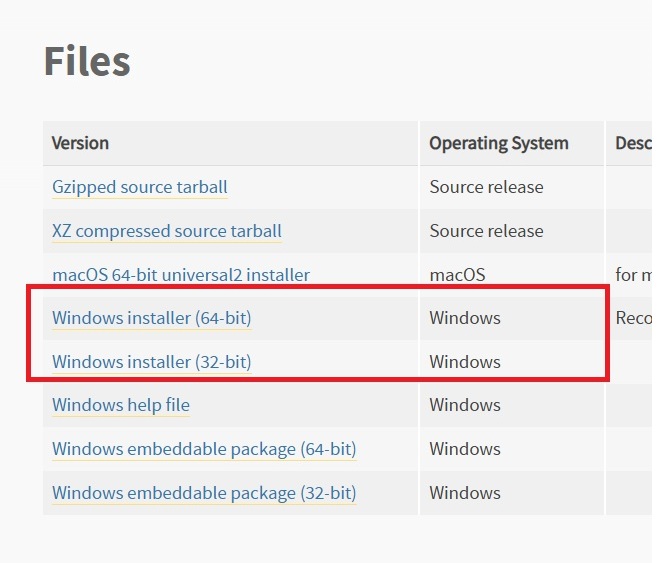

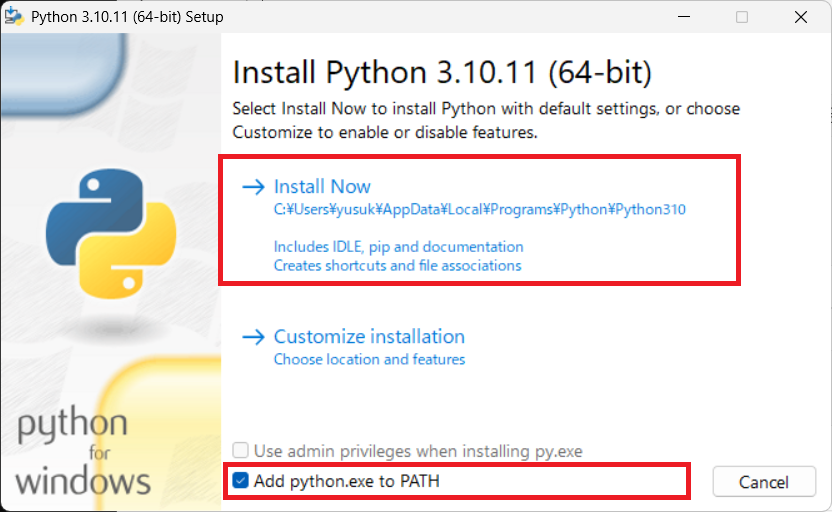

🔶Python 3.10.11のインストール

Python公式サイトの下のほうにあるWindows installer (64-bit)又は自分の環境に合わせて32-bit版からダウンロード

👆インストール時に『Add Python to PATH』にチェックは必ず入れてください!

🔶コマンドプロンプトで下記コマンドをコピペ実行

(ページ下部の検索窓の検索窓に『cmd』と入力すると、コマンドプロンプトが出てくるはずです)

※ターミナル(PowerShell)でも実行可能ですが、コマンドプロンプトを使用した方が、起動までスムーズに進められるケースが多い印象です。

↓

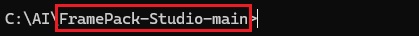

👇まずこのように入力し、コマンドプロンプトにて先ほど展開しFramePackStudioフォルダに移動します。

※この例では

C:\AI\フォルダ内に FramePackStudio を配置したと仮定しています。

下記コマンドを入力実行します。(仮想環境下推奨)

①pip install -r requirements.txt

FramePack Studio起動に必要な部品を一気に入れるコマンドです。

②pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

※FramePack Studioの動作には、RTX 30XX や 40XX シリーズのGPUであれば、上記のコマンドでインストールしたPyTorch(CUDA 11.8対応)で問題ない場合が多いです。

ただし、環境によってはエラーが出ることもあるため、その際はお使いのCUDAバージョンに合わせて「cu118」の部分を以下のように変更してください👇pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121👈この最後の数字の部分です

✅ cu121 → CUDA 12.1 対応

✅ cu118 → CUDA 11.8 対応

✅ cu117 → CUDA 11.7 対応 など

自分のCUDAバージョンを確認したい場合は、以下のコマンドを実行してくださいnvcc --version

cu121 までです。cu122 以降も公式ビルドは存在しますが、バージョンとビルドを明示的に指定する必要があり、初心者にはやや難易度が上がります。ですのでCUDA 12.2以上をご利用の方も基本的には cu121 用のPyTorchをインストールしてください。

また、最新の cu121 をインストールしてもエラーが発生する場合は、cu118 に切り替えて試すのも一つの手です。

(※当方の環境(RTX 3060使用)では cu121 では正常に起動せず、cu118 に変更することで問題なく動作しました。)

③

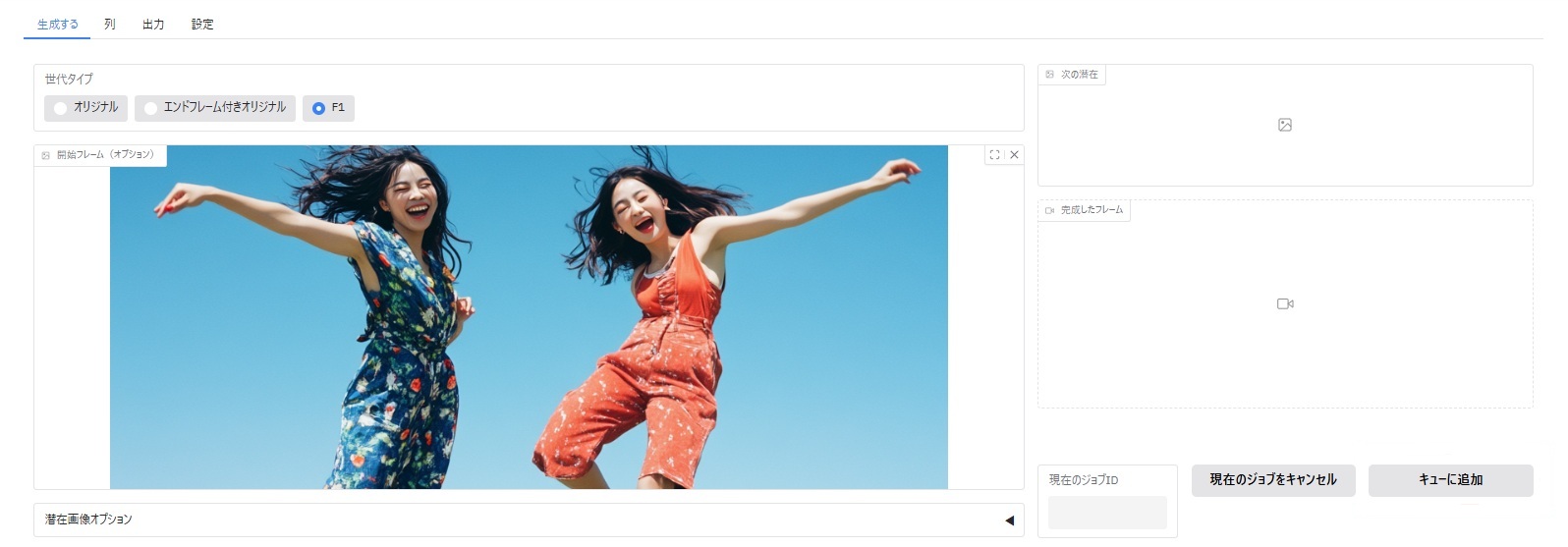

python studio.py --inbrowserFramePackStudioをブラウザで起動

以上の実行で当方の環境では起動致しました。

👇このような画面がブラウザの新しいタブに開けば、起動完了です!

🔶高速化ライブラリsageAttentionのインストール

ここまででFramePack Studioの基本的なセットアップは完了です。

このままでも問題無く使えますが、「生成処理がちょっと時間かかるな、、、」と感じた方へ、高速化ライブラリ「SageAttention」の導入もおすすめです(※任意です)

導入はとってもカンタンで、コマンドプロンプトで下の2行を実行するだけ👇

①pip install triton-windows

②pip install sageattention

※「① → ②」の順番で行ってください。

私の環境(RTX 3060 12GB)では、SageAttentionを入れることで1秒あたりの生成時間が6分→4分程度まで短縮されました。

劇的ではないかもしれませんが、じわっと効いてくる感じなので、試す価値はあると思います。

なお、有名な高速化ライブラリ「Xformers」もありますが、導入難易度がやや高めです。チャレンジしてみたい方は、別記事も参考にしてみてください。

一方、SageAttentionは比較的トラブルも少なく、初心者でも導入しやすいのが魅力です。

当方の環境では、2つの高速化ライブラリを併用しても大きな差は見られませんでした(むしろSageAttention単体のほうが高速でした)。

そのため現時点では、特にこだわりがなければSageAttentionのみで十分だと思われます。

🔶【SageAttention2について】

SageAttention2という高速化ライブラリも存在しますが、

こちらはSageAttentionよりもインストール手順が少し複雑になっており、初心者の方にはややハードルが高く感じられるかもしれません。導入方法の詳細は長くなるため、興味のある方はこちらのGitHubページをご覧ください。

ちなみに、動画生成処理速度は当方の環境ではSageAttentionとほぼ同じ結果となりました。

より高性能な最新のGPUを使う場合や、さらに大規模なモデル・推論処理を行う場合には大きな違いが出る可能性もありますが、少なくともFramePack&RTX 3060での使用では実質的な速度差は感じられませんでした。

参考に各ライブラリ導入時のRTX3060使用時の1秒間の生成時間の目安です👇

| 状態 | 動画生成時間(1秒) |

| 高速化ライブラリなし | 6分38秒 |

| Xformers 導入時 | 5分11秒 |

| SageAttention 導入時 | 4分09秒 |

| SageAttention2 導入時 | SageAttentionとほぼ同じ |

💻【FramePackStudio起動時環境】

・Windows 11

・RTX3060(VRAM 12GB)

・Python3.10.11

実行時の環境で使用していた主なライブラリ一覧になります。

Package Version

--------------------- ------------

accelerate 1.6.0

decord 0.6.0

diffusers 0.33.1

einops 0.8.1

fastapi 0.115.12

ffmpy 0.5.0

gradio 5.25.2

gradio_client 1.8.0

groovy 0.1.2

httpx 0.28.1

huggingface-hub 0.31.4

numpy 1.26.2

opencv-contrib-python 4.11.0.86

orjson 3.10.18

peft 0.15.2

pillow 11.1.0

pydantic 2.11.4

pydantic_core 2.33.2

pydub 0.25.1

requests 2.31.0

safehttpx 0.1.6

safetensors 0.5.3

sentencepiece 0.2.0

tokenizers 0.20.3

torch 2.7.0+cu118

torchaudio 2.7.0+cu118

torchvision 0.22.0+cu118

transformers 4.46.2

tqdm 4.67.1

uvicorn 0.34.2

triton_windows-3.3.0.post19-cp310-cp310-win_amd64.whl

sageattention-1.0.6-py3-none-any.whl